历史上*次有公司会连续开 12 天的产品发布会——当 OpenAI 宣布这个决定之后,全球科技圈的期待值被拉满了。但直到发布会接近尾声,「就这?就这?」一位 AI 从业者如此表达他的观感。

这似乎代表了某种主流看法:此次 OpenAI 发布会,亮点不大、低于预期。

前十一天,OpenAI 的发布会涉及技术、产品形态、商业模式和产业生态等多个重要更新,包括完整的推理模型 o1、强化微调、文生视频 Sora、更强的写作和编程工具 Canvas、与 Apple 生态系统的深度整合、语音和视觉功能、Projects 功能、ChatGPT 搜索、给 ChatGPT 打电话和 WhatsApp 聊天等等。

但正如上述 AI 从业者感到失望的原因,「还以为会发 GPT-5。」在发布会结束第二天,据外媒报道,OpenAI 的 GPT-5 研发受阻。

不过,最后一天发布的 o3 是个例外。它是 o1 的下一代推理模型,在数学、代码、物理等多项测试中表现惊人——一位国内大模型公司的技术人士谈及 o3 给他带来的震撼,「AGI 已来。」他说。技术人士对 o3 评价都颇高。

回顾这 12 天的发布会,OpenAI 一边秀出了技术「肌肉」,另一边不断优化产品形态、扩大落地应用的空间。有人打趣道,就像一场「直播带货」,OpenAI 希望吸引更多用户、开发者使用 ChatGPT。在新的一年,OpenAI 在日活、营收等数据上或许会迎来飞跃。

但这个过程不一定会顺利。尽管模型能力变强,但由于数据掣肘、封装能力、模型成本过高等原因,强大模型和应用落地之间仍有较大距离。

OpenAI 此次发布会似乎透露出这样一种趋势:目前大模型行业的竞争焦点不仅在于模型参数和技术上限,也在于用户体验和市场规模。需要两者齐头并进,才能保持*。

在梳理了 OpenAI 这 12 场发布会的主要信息、以及与国内大模型行业人士交流后,极客公园总结了以下几个关键看点。

01

o3 的智能深度已经够了,

但能否称之为 AGI 要看智能广度

「疯狂,太疯狂了。」这是国内某模型负责人看到 o3 之后的*反应。

在数学、编码、博士级科学问答等复杂问题上,o3 表现出了超越部分人类专家的水平。比如,在涉及生物学、物理学和化学的博士级科学考试 GPQA Diamond 中,o3 的准确率达到 87.7%,而这些领域的博士专家只能达到 70%;在美国 AIME 数学竞赛中,o3 取得 96.7 分、只错了一道题,相当于*数学家的水平。

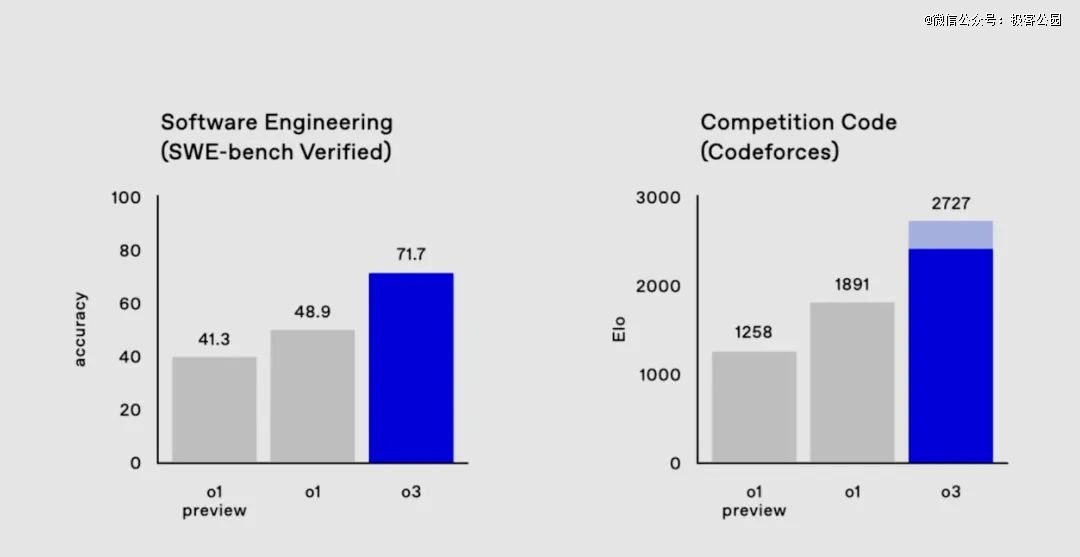

被广为讨论的是其代码能力。在目前全世界*的算法练习和竞赛平台 Codeforces 上,o3 得分为 2727 分、相较 o1 提升了 800 多分,相当于位列 175 名的人类选手。甚至,它超过了 OpenAI 的研究高级副总裁 Mark Chen(得分 2500 分)。

o1-preview、o1、o3 的代码能力对比 | 图片来源:OpenAI

自 9 月推出 o1-preview 版本以来,短短三个月时间内,o1 系列模型在推理能力上完成了*进化。在发布会*天推出的 o1 完整版,其思考速度较 o1-preview 提高了约 50%、针对困难现实问题的重大错误减少了 34%、同时还支持多模态输入(可识别图像)。而今天的 o3 在复杂问题上则已超越部分人类专家水平。

「从 o1 到 o3 是通过增加推理计算量实现对模型能力的提升,随着国内外 Deepseek-R1、Gemini 2.0 Flash Thinking 等发布,表明大模型开始从预训练 Scaling Law 转向推理的 Scaling Law。」清华大学长聘副教授、面壁智能发起人刘知远对极客公园表示。

自 OpenAI 发布 o1-preview,大模型浪潮的技术范式从最初的预训练 Scaling Law(缩放定律),即不断扩大模型训练参数、提升其智能上限,切换到了新一轮的、升级的技术范式,即在推理阶段注入强化学习、提高复杂推理能力。

在前一种范式下,模型主要是通过 next token prediction(下一个词预测)给出答案,更偏向「快思考」。就像「读了万卷书」,但「学而不思则罔」,没法完成数学、编程等更复杂的推理任务。

而在后一种范式下,模型不会马上给出答案,而是会「慢思考」,先引入 CoT(思维链),把复杂的问题规划、分解为更简单的步骤,最后得到结果。而当方法不起作用时、它会尝试另一种方法,在强化学习中提升复杂推理能力——随着模型不断进行「慢思考」和强化学习,其推理能力会指数级上升,这就是推理的 Scaling Law。

对于 o3 超出人类专家的*研究推理能力——在刘知远看来,这表明 o3 正在朝「超高智能的超级计算机」方向前进。

不少行业人士认为,这会对前沿科学领域影响深远。从积极的角度来看,o3 极强的研究推理能力,能够帮助推动人类在数学、物理学、生物学、化学等学科的基础科学研究。不过,也有人担心它会冲击科研人员的工作。

此次 o3 带来的惊人的智能深度,似乎让人看到了 AGI 的曙光。但在刘知远看来,正如信息革命的标志并非大型计算机、而是个人计算机(PC)的普及,只有实现 AGI 的大众化、普惠化,即让每个人拥有自己的大模型、解决好自己日常的问题,才意味着真正的智能革命。

「毕竟我们并不需要让陶哲轩、Hinton(均为*科学家)来为我们解决日常问题。」他说。

这背后涉及的关键问题是,o3 模型的智能深度能否泛化到其他各种领域、具有足够的智能广度——在上述某国内大模型公司的技术人士看来,只有同时突破智能的深度、广度,才能称之为 AGI。他对此感到乐观,「就像你们班来了一个转校生,你没跟他接触过,但他考试数学和编程都考了全班*。你觉得他语文和英语会很差吗?」

对于国内的大模型公司来说,核心的问题还是如何追赶 o3。从训练架构、数据、训练方法和评价数据集等关键要素来看,这似乎是工程化能解决的问题。

「你认为距离我们拥有一个 o3 水平的开源模型还有多远?」

「一年之后。」上述模型负责人回答。

02

模型只是发动机,

关键是帮助开发者用起来

尽管 o3 的模型能力很强,但在一些应用层人士看来,模型和落地应用之间还有很大距离。「今天 OpenAI 训练了爱因斯坦,但如果想变成上市公司的首席科学家,依然是有距离的。」澜码科技创始人兼 CEO 周健对极客公园表示。

作为大模型中间层,澜码科技是国内较早探索将大模型应用落地、打造 AI Agent 的公司。在周健看来,大模型只是一个基础设施,需要结合场景去做很多工作才能用起来,而目前主要的掣肘是数据。

在很多场景里,拿到完整数据是很难的,有很多数据甚至是没有数字化的。比如猎头可能需要简历数据,但很多简历数据并没有被数字化。

而成本是影响 o 系列模型落地的最关键因素。根据 ARC-AGI 测试标准,o3-low(低计算量模式)每个任务耗费 20 美金,o3-high(高计算量模式)每个任务耗费数千美金——哪怕问一个最简单的问题,也要花费近两万元。收益和成本根本不能打平,o3 的落地可能还需要漫长一段时间。

在帮助模型应用落地的问题上,OpenAI 在发布会上也发布了相应的功能方案。比如第二天,OpenAI 专为开发者发布了 AI 强化微调(AI Reinforcement Fine-Tuning)功能,这是周健最关心的功能。它指的是,模型能通过少量数据,优化推理能力、提升性能。

这尤其适用于精细化领域的应用。OpenAI 技术人士称,它能帮助任何需要在 AI 模型方面拥有深厚专业知识的领域,比如法律、金融、工程、保险。一个例子是,最近汤森路透使用强化微调来微调 o1-mini,得到了好用的 AI 法律助理,帮助他们的法律专业人员完成了一些「*分析性的工作流程」。

比如第九天,o1 模型终于向开发者开放使用。它支持函数调用和视觉能力;引入了 WebRTC,实现实时语音应用开发;推出了偏好微调功能,帮助开发者定制模型;发布了 Go 和 Java SDK,让开发者可快速上手集成。

同时,它带来了更低成本、更高质量的 4o 语音模型。其中,4o 音频价格下调 60%,降至输入 $40/百万 tokens、输出 $80/百万 tokens,缓存音频价格降低 87.5%、至 $2.50/百万 tokens;对于预算有限的开发者,OpenAI 推出 GPT-4o mini,音频费用仅为 4o 的四分之一。

这个新功能也是周健关注的。他认为,更新的实时语音、视觉识别等功能,将能更好地在营销、电话客服和销售外呼等场景应用。按他的经验,当 OpenAI 推出某些*技术,一般国内 6-12 个月就可以追上。这让他对新一年的应用业务充满信心。

03

Sora 的视频生成低于预期,

但产品开放会提升其物理模拟能力

年初 OpenAI 发布 Sora 的 demo 时,引发了全球科技圈的震撼。但这一整年,国内各大模型公司纷纷竞逐文生视频赛道——等到 OpenAI 在发布会第三天正式放出 Sora 时,国内的文生视频公司松了一口气。

「基本没有什么超出预期的内容,真实感、物理特性等方面相比于 2 月份的发布并没有显著变化,从基础模型能力的层面来说算是低于预期的。」生数科技联合创始人兼 CEO 唐家渝对极客公园表示。

目前,字节、快手、MiniMax、智谱、生数、爱诗等公司均推出了自己的文生视频产品。「Sora 的效果和实力综合来看并无明显*优势,我们看到自己与OpenAI确实还是齐头并进的。」唐家渝表示。

在他看来,Sora 稍微有亮点的部分是在基础的文生视频、图生视频以外,提供了一些提升视频创作体验的编辑功能,说明 OpenAI 确实更关注产品体验了。

比如故事板功能,它相当于按时间轴的方式,把一段故事(视频)切成了多个不同的故事卡(视频帧)。用户只需要设计和调整每张故事卡(视频帧),Sora 会自动把它们补成一段流畅的故事(视频)——这很像电影里的分镜、动画的手稿,当导演画好分镜、漫画师写好手稿、一个动画、片子就做好了。它能让创作者更好地表达自己。

此外,它还推出了文字直接修改视频、无缝融合两段不同的视频、给视频改变画风等功能,它们相当于是直接给视频加「*」了。而一般的文生视频产品,无法直接修改原视频,只能不断调整 prompt(提示词)、生成新视频。

在唐家渝看来,这些功能设计确实都是为了给创作者更大的创作自由度,类似的功能已经在 Vidu(生数科技的文生视频产品)迭代的计划中。「Sora 这些功能的实现对于我们来说并没有难度,实现路径也已经非常明确了。」他说。

在发布会上,Sam Altman 阐释了做 Sora 的原因:一是工具性价值,为创意人员提供创作工具;二是交互价值,大模型不应只通过文本交互,也应扩展多模态;三是最重要的——它和 AGI 技术愿景是一致的,Sora 在学习更多关于世界的规律,最终有可能建立理解物理规律的「世界模型」。

在唐家渝看来,目前 Sora 生成的视频中,依然有不少明显违背物理定律的地方,跟 2 月的 demo 相比进步不大。在他看来,Sora 发布后、会有更多人来尝试和探索它的物理模拟能力,这些测试样本或许对提升它的物理模拟起到一定的指导作用。

04

内加功能、外接生态,

ChatGPT 能变成 Super App 吗?

在 o 系列模型、Sora、以及开发者服务之外,OpenAI 在发布会上的主要动作,一方面还是在产品侧持续增加新功能,优化用户体验。另一方面是积极推动与苹果等企业的深度合作,探索 AI 融入终端设备和操作系统。

从前者可以看到,ChatGPT 的演进方向,似乎是要成为一个「无所不能、无所不在、人人可得」的超级 AI 助理。据极客公园了解,OpenAI 创立之初的愿景就是打造一个「无所不能」的 Agent,它能理解人类的指令、自动调用不同的工具、满足人类的需要。看起来,终点即起点。

比如第六天,ChatGPT 增加了支持屏幕共享的视频通话和圣诞老人语音模式。前者让用户能与 AI 实时视频通话,分享屏幕或展示周围环境,进行多模态互动,复现了电影《Her》的场景。

比如第八天,ChatGPT 向全体用户开放了其搜索功能。在基础搜索外,它还增加了语音搜索;同时,它集成了手机设备的地图服务,能调取苹果、谷歌地图展示搜索结果列表;它还与多家*新闻和数据提供商建立了合作关系,支持用户查看股票行情、体育赛事得分、天气预报等信息。

又比如第十一天,ChatGPT 宣布扩展了与桌面软件的集成。它能接入更多编码应用程序,如 BBEdit、MatLab、Nova、script Editor 等;它能和 Warp(文件共享应用)、XCode 编辑器等应用一起使用;它还能在语音模式下与其他应用程序协同工作,包括 Notion、Apple Notes 等;

现场演示有这样一个例子,当用户在 Apple Notes 中设定「节日派对歌单」,并语音征询 ChatGPT 对候选歌曲的意见。ChatGPT 能指出用户的错误,如将圣诞歌曲《Frosty the Snowman》误写为《Freezy the Snowman》。

「ChatGPT 会从单纯的会话助手向更为强大的代理工具转变。」OpenAI 首席产品官凯文·韦尔(Kevin Weil)称。

而另一方面,OpenAI 也在积极扩张生态,通过融入人们最常用的终端设备、操作系统、上层软件等,触达更广泛人群。

比如第五天,ChatGPT 宣布集成苹果智能生态,融入 iOS、MacOS 和 iPadOS,支持用户跨平台、跨应用调用 AI 能力,包括 Siri 交互、写作工具(Writing Tools),以及视觉功能智能识别场景内容(Visual Intelligence)等。通过这次合作,ChatGPT 触达了全球数十亿苹果用户。它也开启了大模型与端侧、操作系统合作的先例。

比如第十天,ChatGPT 公布了自己的电话联系方式(1-800-242-8478),美国用户每月可拨打该号码享受 15 分钟的免费通话。同时上线的还有 WhatsApp 联系人(1-800-242-8478),全球任何用户均可通过 WhatsApp 向该号码发送消息,目前只限文字信息。

全球部分国家、地区的智能手机和移动互联网渗透率还远远不足,通过电话这种最基础的通讯工具,ChatGPT 触达了这些人群。同时它也通过 WhatsApp,触达了其近 30 亿用户。

无论是内加功能、还是外接生态,ChatGPT 核心是希望产品触达更广泛人群,变成真正的 Super APP。但也有人并不看好它这种不断内加功能、将业务线拉得无尽长的做法,甚至将其形容为「铺了一个大饼,但每一块饼都有点薄,深入不下去」。而很多业务都需要足够深才能发挥价值、也有对应的公司在深耕,这或许是 OpenAI 要面临的挑战。

尽管 o3 模型让外界看到了 OpenAI 惊人的技术实力,但关于推理的 Scaling Law 能达到怎样的智能上限、以及 GPT-5 的难产问题,依然让外界对这家公司的技术发展充满疑虑。这次发布会上,OpenAI 将关注点转而放在产品形态、合作生态和落地建设上,也未尝不是一种思路。这两者的结合,可能决定了行业接下来的走向。

241912/25

241912/25