最近,两大知识平台开始“反击”大模型。

一是知网。就是引发学术界震动、开启“天临元年”的那个知网,要求秘塔AI搜索终止对他们内容的搜索和链接。

二是知乎。网友发现在微软必应搜索、谷歌搜索的结果中,知乎内容的标题和正文都可能是乱码,极大可能是为了避免内容被用来训练AI模型。

这两大平台区别于其他互联网社区的一大特点,就是知识内容丰富、质量较高。

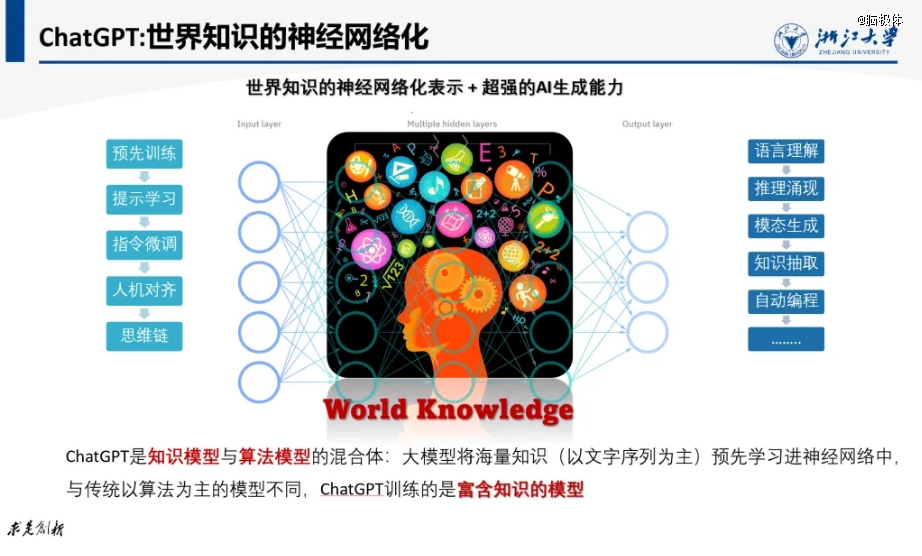

对于大模型来说,“知识密度”是一个非常关键的指标,就像集成电路领域的“先进制程”一样,如果说高制程芯片能够在同样面积上集成更多的晶体管,那么“知识密度高”的大模型,能够在同样的参数空间内学习并存储更多的知识,从而更好地完成特定领域的任务。

半导体领域的“先进制程”封锁,一直是拿捏中国芯片的有效手段。

那么,头部知识平台对大模型采取“关门政策”,会影响到大模型及AI产品的先进性吗?

我们的观点如标题所示,大模型是不会被“知识围城”而封锁的。

比起结论,更值得进一步探讨的是,既然大模型训练对平台内容并没有高度依赖,模厂和平台的矛盾是从何而起呢?

1、知识,AI产业化的核心

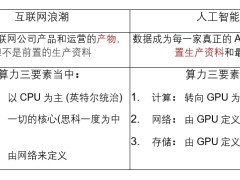

很多读者都听说过AI三要素,是数据、算力、算法。知识处于什么地位呢?凭什么大模型知识密度,具有半导体“先进制程”一样的重要性呢?

清华大学张钹院士说过,当前大模型存在难以逾越的天花板,“推动AI的创新应用与产业化,四个要素肯定都要发挥知识、数据、算法、算力,但是我们最主张的,就必须重视知识的作用,所以我们把知识放在*位”。

可能有人又会问,院士说得就一定对吗?当然不一定。我们还可以来看看一线的从业者,又是怎么想的。

我听过某AI创业公司,在交付产品时,发现即便是基于GPT4-Turbo这样性能*的基座模型,AI也对很多问题答不上来。因为有些场景会用到一些隐性知识,这些知识是下一步推理所必需的,但模型经常get不到。

比如生成一道菜谱,其中提到了“加辣椒”,但辣椒有点辣(隐性知识),就需要询问用户“喜不喜欢吃辣”,人类厨师早就了解这个基础知识,但让AI主动意识到并询问就很难。

这是因为缺少“通识知识”。

某金融券商想用大模型来替代人类理财师,发现大模型给出的理财观点和建议很泛泛,是一些常识性内容,而用户在决策时,需要的是人类专家那样犀利的洞见。

一位金融从业者说,有些场景,大模型fine tuning还不如传统的小模型,怎么把业务知识注入大模型中,做了各种尝试也没有特别好的方法,只能把飘在上面的问题数据,收集来达标给LLM,希望它下次不要再犯错。

而另一个创业公司发现,如果从小处着手,将LLM与行业知识融合,可以获得97%以上的准确率,基本能达到行业客户的验收标准。实际上,很多AI创业公司的大模型ToB项目,都是帮助企业构建定制化知识库(KB系统)。

领域知识,则是关乎大模型处理复杂专项任务、收获商业成功的第二道壁垒。

所以,很多模厂都希望模型通过持续学习,来不断吸收新知识,这又带来了新的问题——修改核心参数,这可能影响到模型的原有性能,有可能直接崩掉,不work了,这是业务的大敌。

咋办呢?还是得靠知识。

一方面,原本知识密度就高的大模型,相当于人类具备很强的通识基础,提前了解了很多背景知识,所以泛化能力很强,可以在面对新领域、陌生任务时,快速学习、举一反三。所以,知识密度可以让大模型具备跨领域、自学习的能力,通过“知识回路”就能学会新知识了。这就减少了人工干预,从而降低了故障率。

另外,高效、精准的知识编辑,可以对大模型中的知识进行新增、擦除等操作,就可以用很小的代价,实现模型的迭代升级。让模厂在保持模型先进性的同时,也不影响到现有业务的持续性。对于业务不能中断的金融、政务、电力、工厂等行业客户,简直不要太有吸引力。

此外,一些实际业务中,不希望大模型在生成时说出来的话,比如一些隐私信息,或者有害有毒内容、政治偏见等,都需要知识编辑技术来进行“祛毒”,精准地识别毒性区域并擦除有毒内容,真正做到给大模型“洗脑”。

由此可见,知识是AI商业化全流程都必须关注的。业界一度有着“得知识者得天下”的风向。有模厂提出了大模型知识的“摩尔定律”,认为大模型的知识密度,应该每隔8个月就翻一倍,同等知识量的模型参数量减半。

那反过来想一想,失知识者岂不是要失天下了?

2、平台围城,围不住草原

知识平台,是人类知识汇聚的重要渠道,OpenAI、谷歌等海外AI公司都与优质媒体内容平台有商业化合作,用授权内容来训练自家模型。

既然如此,为什么我们会说,大模型其实并不担心平台的“知识封锁”呢?

因为人类知识平台,不再是模型不得不进的“围城”。

如果说原始数据是“草”,而知识是牛奶,那么传统知识获取,是让机器“喝的是奶,产的也是奶”。就像20世纪的专家系统,根据一个或者多个专家提供的知识和经验,通过模拟专家的思维过程,让机器能够解决问题。

这种情况下,实现机器智能就必须依赖由人类领域专家,以及专家知识库。要“进城”获取知识,必须给平台“城主”交过路费。

但大模型不一样的地方,一是“不是必须喝奶,吃草也行”,可以直接从原始数据中挖掘知识、抽取知识。DeepMind联合创始人哈萨比斯曾经设想过,未来的大模型可以直接从与客观世界的感知交互过程中,利用深度学习算法来总结知识,并直接用于决策。

二是“不依赖人产奶,自己也行”,通过数据驱动的大规模自动化的知识获取,反哺模型。

ChatGPT、GPT4都具备较强的知识图谱建构能力,按照要求抽取知识,正确率可以达到88%,这种“生产效率”可比人类写论文、在问答平台“谢邀,刚下飞机,答一下”,要快得多。

更进一步,业界还在研究能够大规模编码和处理各种知识表示结构的大型知识模型(Large Knowledge Model)。从LLM到LKM,对现有人类知识的依赖越来越低了。

所以,是否收录基于人类知识的平台内容,其实对大模型训练来说,影响已经很小了。

“吃的是草,吐的是奶”的模型,可以在大数据的旷野上生存,并不一定要进知识平台这座“围城”,“关门”也就关门吧。

所以我们看到的后续就是,秘塔AI搜索在收到知网的函件之后,表示“学术”版块仅收录了论文的文献摘要和题录,并未收录文章内容本身。而且还主动“断链”,不再收录知网文献的题录及摘要数据,转而收录其他中英文权威知识库的文献题录及摘要数据。类似的,被知乎以乱码干扰的谷歌搜索、微软必应搜索,模型能力依然*。

3、知识封锁,到底锁住了谁?

那么,知识平台的反应,难道是过度反应、虚空索敌吗?平台究竟想“锁”住什么,恐怕才是值得关注的真问题。

首先,没必要利用人类知识来训练模型,并不是说大模型厂商就一定不会侵权。

目前,全球模厂都面临高质量语料匮乏的隐忧,数据焦渴之下,在未授权的情况下,用到有知识产权的数据是可能发生的。

在某次采访中,OpenAI的CTO就对“视频训练数据是否来自YouTube等公开网站”等问题避而不谈。此前,《纽约时报》曾因商谈“内容付费”没有成效,将OpenAI和微软告上法庭,指控他们未经授权就使用该机构的数百万篇文章来训练AI模型。

而前不久,微软就与学术出版商Taylor & Francis签署了一项价值1000万美元的协议,允许微软访问其数据来改进AI系统。

由此可见,虽然AI领域的知识产权问题仍然有很多盲区,但与知识平台达成版权合作,应该被模厂及其客户,纳入AI合规和持续性经营的考量中。

此外,即使侵权问题并不存在,但价值冲击也会发生。

具体来说,AI搜索等新一代AI产品,对知识平台的冲击有两方面:

一是流量价值冲击。尽管秘塔AI搜索声明中提到,向用户提供的是知网的学术文献题录及摘要数据,用户要进一步浏览正文,要通过来源链接跳转至网站获取。但搜索引擎将触角伸到网站,用户就会减少访问与站内搜索,从而影响平台的流量和潜在收益,类似于微信此前阻止百度搜索到公众号内容一样。

二是知识价值冲击。基于大模型的AI搜索具备总结、生成等能力,而由于模型可能存在“过拟合”问题,也就是AI自己“脑补”,最终可能输出给用户的内容与原文高度一致,没直接侵权但胜似侵权。

此前就有很多小说作者发现,模型生成的故事大纲与走向与自己写的高度类似,怀疑云文档被用来训练AI模型,但极有可能是AI跟人类作者“撞脑”了。

大模型经济的核心价值,是知识的创造与分发。

一位朋友说,“以前有问题,我会上网问知乎,但有些问题我不想让公众知道,以后我就问基础大模型+领域知识+AI Agent打造的专业bot,一次到位”。Perplexity CEO曾明确说过,“我们想成为世界上最以知识为中心的公司”,秘塔AI搜索经常被比作中国的Perplexity。

可以看到,即使没有侵权纠纷,AI企业及产品,也与知识平台,在商业层面形成了直接的替代和竞争关系。

失知识者失天下,从这个角度来说,的确成立。

大模型在数据旷野上狂飙突进,知识平台能否靠“关门上锁”来守住核心价值呢?或许大家心中已经有答案。

54808/28

54808/28