亚马逊已达成协议,以8000 万美元现金收购芯片制造商和 AI 模型压缩公司Perceive ,后者是上市公司Xperi位于加州圣何塞的子公司。Perceive 是一家开发突破性神经网络推理解决方案的公司,专注于在边缘设备上提供大型人工智能模型的技术。

亚马逊并未透露对这项技术的具体想法。亚马逊发言人表示:“我们很高兴签署了收购 Perceive 的协议,并引入其才华横溢的团队,加入我们的努力,为能够在边缘运行的设备带来大型语言模型和多模式体验。”

Xperi 自今年初以来一直在为 Perceive 寻找买家。交易完成后,Perceive 的 44 名员工中的大部分预计将加入亚马逊。亚马逊表示,预计该交易不需要监管部门批准,并称这是一次常规收购。

Perceive的芯片介绍

资料显示,Perceive 由联合首席执行官 Murali Dharan 和 Steve Teig 领导。该公司的员工遍布全球。该公司将在爱达荷州运营一个实验室。Teig 在担任 Xperi 首席技术官期间推动了 Perceive 的创建,他负责监督技术开发,包括核心音频和成像创新,同时还领导公司的机器学习团队。Dharan 之前负责 Xperi 授权业务的战略方向、管理和增长,现在负责领导 Perceive 的业务运营,包括销售、营销、客户成功和运营。

Perceive 提供在边缘设备上服务大型AI 模型的产品,穷旗舰产品是 Ergo AI 处理器,它可以在各种环境中运行数据中心级神经网络,即使在电力受限的情况下。

据介绍,这是一款为边缘设备带来突破性性能和能效的 AI 处理器。能够以全帧速率运行大型神经网络,并支持各种网络架构和类型,包括标准 CNN、RNN、LSTM 等。Ergo足够灵活和强大,可以处理大量机器学习任务,从对象分类和检测,到图像分割和姿势,再到音频信号处理和语言。你甚至可以要求它执行多任务,因为Ergo 可以一次运行多个网络。

尽管 Ergo 处理能力强大,但它不需要外部 DRAM,其 7 毫米 x 7 毫米的小封装使其非常适合用于相机、笔记本电脑或 AR/VR 眼镜等紧凑型设备。

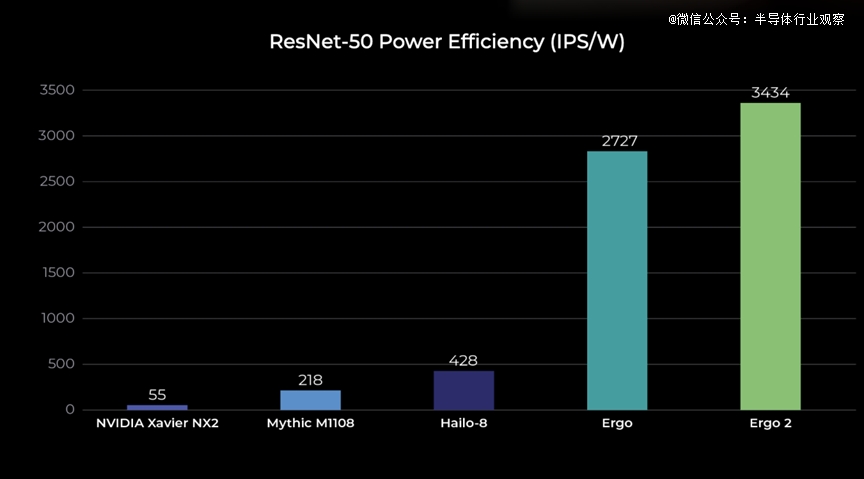

Perceive表示,Ergo 的能效是其他产品的 20 到 100 倍,仅需 9 mW 的计算能力即可对 30 fps 的视频进行推理。这意味着您的设备可以提供*的电池寿命,并产生更少的热量,从而实现更小、更多功能的封装。

在2023年初,Perceive推出了新款Ergo 2 AI 处理器。据介绍,该芯片可提供更复杂用例所需的性能,包括需要变压器模型、更大的神经网络、同时运行的多个网络和多模态输入的用例,同时保持行业*的功率效率。

Perceive 创始人兼首席执行官史蒂夫·泰格 (Steve Teig) 在阐述了最新 Ergo 芯片的市场机会的时候表示:“借助新的 Ergo 2 处理器,我们扩展了为设备制造商提供打造其最雄心勃勃的产品的途径的能力,”“这些产品包括用于语言或视觉处理的变换模型、更高帧速率的视频处理,甚至在单个应用程序中组合多个大型神经网络。”

Ergo 2 的运行速度比 Perceive 的*代 Ergo 芯片快四倍,处理能力也远超为微型 ML 设计的典型芯片。现在,产品开发人员可以利用 YOLOv5、RoBERTa、GAN 和 U-Nets 等先进神经网络快速提供准确结果。所有 Ergo 2 处理均在芯片上完成,无需外部存储器,从而提高能效、隐私性和安全性。Ergo 2 芯片可实现:

运行 MobileNet V2 每秒进行 1,106 次推理

运行 ResNet-50 时每秒进行 979 次推理

运行 YoloV5-S 每秒进行 115 次推理

为了提供运行这些大型网络所需的性能增强,Ergo 2 芯片采用流水线架构和统一内存设计,从而提高了其灵活性和整体运行效率。因此,Ergo 2 可以支持更高分辨率的传感器和更广泛的应用,包括:

语言处理应用,例如语音转文本和句子完成

音频应用,例如声学回声消除和更丰富的音频事件检测

要求苛刻的视频处理任务,例如视频超分辨率和姿势检测。

Ergo 2 处理器尺寸为 7 毫米 x 7 毫米,由 GlobalFoundries 使用 22FDX平台制造,无需外部 DRAM 即可运行。其低功耗也意味着它不需要冷却。该芯片可以同时运行多个异构网络,为用于安全、访问控制、热成像或零售视频分析的企业级摄像机等设备提供智能视频和音频功能;适用于包括视觉检查在内的工业用例;或集成到笔记本电脑、平板电脑和高级可穿戴设备等消费产品中。

AWS的自研芯片历程

多年来, AWS 一直在为AI 工作负载和云优化构建自己的内部定制硅片,这主要得益于公司在十多年前收购了 Annapurna Labs。这让AWS 在过去多年里构建了自己的 Graviton 处理器、Inferentia 芯片和 Trainium 机器学习处理器,用于在云端训练 AI 模型。

今年,亚马逊在推动人工智能 (AI) 技术发展方面迈出了重要一步。

在其年度 AWS re:Invent 大会上,AWS发布了两款新型定制芯片:AWS Trainium2 和 Graviton4。这两款芯片代表了亚马逊网络服务 (AWS) 为满足日益增长的 AI 功能需求而做出的大胆努力,尤其是在市场面临主要由 Nvidia 生产的高性能图形处理单元 (GPU) 严重短缺的情况下。

对增强计算能力的需求源于生成式人工智能的日益普及,这需要强大的基础设施来训练和部署模型。据报道,Nvidia 的 GPU 直到 2024 年都已售罄,包括台积电首席执行官在内的业内消息人士预测,这种供应危机可能会持续到 2025 年。考虑到这一点,亚马逊的新芯片旨在通过提供专门针对人工智能工作负载量身定制的替代方案来减轻对 Nvidia 的依赖。

Trainium2 芯片专为训练大规模 AI 模型而设计,性能比上一代芯片高出四倍,能效比上一代芯片高出两倍。据亚马逊称,这款芯片在多达 10 万个单元的云集群中使用时,可处理 65 百亿亿次浮点运算。这一功能可将训练复杂模型(例如具有数千亿个参数的模型)的时间从数月缩短至数周。这些进步使 Trainium2 成为 AI 训练基础设施领域的领跑者。

Trainium2 芯片因其潜力而受到认可,已经引起了多家行业参与者的兴趣,其中包括专注于构建友好型 AI 模型的公司 Anthropic。联合创始人 Tom Brown 强调,Trainium2 将使他们能够快速扩展,处理速度比之前的模型提高四倍。AWS 与 Anthropic 等公司之间的合作表明,利用专有云技术简化 AI 操作的趋势日益增长。

另一方面,Graviton4 芯片是亚马逊迄今为止最强大、最高效的处理器,专为各种云工作负载量身定制。与上一代 Graviton3 相比,这款第四代芯片的性能有望提高 30%,内核数量增加 50%,内存带宽增加 75%。这些改进使用户能够降低运营成本并提高数据处理速度,使其成为运行高性能数据库和密集分析应用程序的企业的理想选择。

Graviton4 的早期采用者包括 Datadog、Epic Games 和 SAP 等公司。例如,Epic 的首席云工程师 Roman Visintine 就指出,该芯片在延迟敏感型工作负载方面表现出色,尤其有利于在线游戏体验。在竞争激烈的环境中,快速的数据访问和处理对于成功至关重要,这种云服务优化趋势至关重要。

亚马逊的声明也凸显了科技行业更大的趋势,即公司越来越多地投资定制芯片解决方案,以满足特定的计算需求,尤其是人工智能和机器学习任务。通过开发专有硬件,亚马逊希望脱颖而出,减少对 Nvidia 和 AMD 等老牌芯片制造商的依赖。

随着人工智能技术在各个领域(从医疗保健到娱乐)不断发展和普及,对高效、高性能芯片的需求只会越来越大。技术分析师预计,这些新的亚马逊芯片的推出不仅将立即满足当前的需求,还将为未来的人工智能发展奠定基础。

令人惊讶的是,这些芯片的推出正值战略时刻,因为微软也宣布了自己针对人工智能和云服务的芯片开发。这在人工智能硬件领域引发了激烈的竞争,促使企业迅速创新和突破界限。

AWS Trainium2 和 Graviton4 芯片预计将在不久的将来向客户提供,其中 Trainium2 将于明年某个时候推出,而 Graviton4 已处于预览阶段。随着科技行业继续转向云计算和人工智能驱动的解决方案,亚马逊有望在这场数字化转型中发挥重要作用。

AI芯片大有可为

AWS频频发力芯片,除了满足公司业务需求以外,也再次证明了AI芯片大有可为,这不但体现在云端,还体现在端侧。

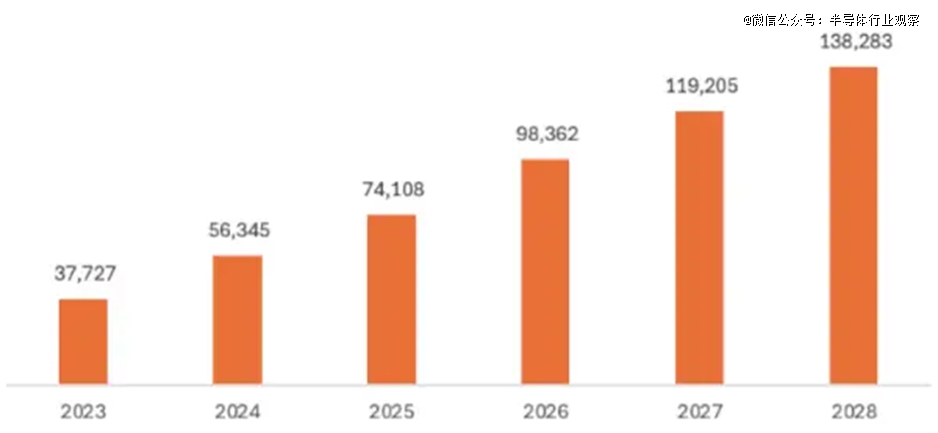

根据 Futurum Intelligence的数据,到 2023 年,Nvidia 将占据 AI GPU 市场 92% 的份额,并占据整个数据中心 AI 半导体市场 75% 的份额。在这个已经非常庞大的市场中,这种主导地位仍将继续,预计到 2024 年市场规模将增长近一半。

该分析公司估计,数据中心人工智能应用的处理器和加速器的总市场价值将达到 563 亿美元,与 2023 年的 377 亿美元的年度市场价值相比增长 49.3%。市场分析师预测,未来五年,该市场的复合年增长率将达到 29.7%,使市场规模在 2026 年达到 984 亿美元,在 2028 年达到 1383 亿美元。

Futurum 将 AI 数据中心处理器市场分为四类:CPU、GPU、专用加速器(称为 XPU)以及谷歌、AWS 和微软等公司生产的专有云加速器。

2023 年,CPU 占据 20.5% 的市场,GPU 占据 73.5% 的市场,XPU 和云专有产品各占 3%。

1、2023 年,CPU 占数据中心 AI 处理的 20%,并将继续发挥重要作用。Futurum 估计,它们的五年复合年增长率将达到 28%,从 2023 年的 77 亿美元增长到 2028 年的 260 亿美元。Futurum 估计,2023 年,Nvidia 的市场份额为 37%,其次是英特尔,占 23%。

2、到 2023 年,GPU 占数据中心 AI 应用中使用的芯片组的 74%,并将经历 30% 的五年复合年增长率,从 2023 年的 280 亿美元增长到 2028 年的 1020 亿美元。Futurum 估计 Nvidia 占据了 AI GPU 市场的 92% 份额。

3、XPU 将经历 31% 的五年复合年增长率,从 2023 年的 10 亿美元增长到 2028 年的 37 亿美元。

4、公共云 AI 加速器将经历 35% 的五年复合年增长率,从 2023 年的 13 亿美元增长到 2028 年的 60 亿美元。

如果 AI 处理器和加速器不能在数据中心供公众使用,Futurum 会将其排除在本研究之外,因此不包括为 meta、特斯拉和苹果设计并使用的 AI 芯片组。

从地域上看,北美占据市场主导地位,到 2023 年将占据 55% 的市场份额。欧洲、中东和非洲 (EMEA) 和亚太地区 (APAC) 紧随其后,成为重要市场,而拉丁美洲 (LATAM) 则代表具有巨大增长潜力的发展中地区。

视觉和音频分析是 2023 年*的用例。Futurum 预测 2028 年的前三大用例将是视觉和音频分析、模拟和建模以及文本生成、分析和摘要。

具体到边缘AI方面,据Omdia的新研究预测,到 2028 年,边缘 AI 处理器市场将创造 602 亿美元的收入,复合年增长率为 11%。

Omdia 最新的边缘处理器预测指出,随着各行各业和设备采用人工智能,对硬件的需求增加推动了收入的增长。推动市场增长的领域之一是个人电脑领域,英特尔、AMD 和苹果等主要供应商的产品供应量不断增加。据报道,PC 供应商正试图将其设备中加入 AI 处理器作为“独特的卖点”进行营销。

除个人电脑领域外,该报告还强调了人工智能处理器在汽车、无人机、安全摄像头和机器人等领域的快速应用。

由此我们可以看到AWS收购背后的用心。

78708/24

78708/24