一个季度赚了123亿美元的英伟达,现在成了许多半导体企业艳羡的对象,大家头一回发现,原来GPU利润这么高,甚至能撑起2万亿美元的市值,但英伟达真的会满足于此吗?

英伟达CEO黄仁勋曾在2008年发表过感言,认为公司应该把研究客户的需求,把解决客户的问题放在*位,而不是去关注对手,如果把精力放在如何从对手那里把客户抢过来,就会错失开拓新客户的机会。

16年之后,英伟达的CEO还是黄仁勋,虽然股价市值规模早已翻了十数倍乃至上百倍,但在他的掌舵下,英伟达依旧走在不断寻找新客户的道路上。

据路透社报道,英伟达正在建立一个新的业务部门,专注于为云计算公司和其他公司设计定制芯片,其中包括先进的人工智能处理器。

据其爆料,英伟达高管已经与亚马逊、meta、微软、谷歌和OpenAI的代表会面,讨论为他们生产定制芯片的事宜,除了数据中心芯片外,英伟达还在寻求电信、汽车和视频游戏的客户。

路透社的这份报道,意味着英伟达要以强势姿态切入数据中心定制芯片市场,要在传统的游戏,新兴的人工智能等领域之后开拓一片新的战场。

那么,英伟达为什么要这么做,它的胜算又有几何呢?

定制双雄

从2020年开始,自研和定制成为了半导体行业的热门词,从苹果发布M1芯片开始,似乎每个厂商都在尝试自研芯片,以此来获得成本上的优势。

但对于超大规模数据中心企业(Hyperscaler)公司来说,他们对于硬件和软件都有接近完全的掌控力,非常适合开发自己专属的SoC,而他们在这方面的研究也确实要早的多,定制化芯片初期*的推动因素,就是来自这些企业对AI,以及云端计算的庞大需求。”

早些年靠AlphaGo一炮而红的谷歌,就是定制化芯片的先行者。

2013年,Google AI负责人Jeff Dean经过计算后发现,如果有1亿安卓用户每天使用手机语音转文字服务3分钟,其中消耗的算力就是Google所有数据中心总算力的两倍,而全球安卓用户远不止1亿。

此时谷歌已经意识到,光靠通用的CPU和GPU已经无法满足未来的庞大计算需求,而出路就是选择定制芯片,为此,它定下了一个目标:针对机器学习这一目的来构建特定领域计算架构(Domain-specific Architecture),还要将深度神经网络推理的总体拥有成本(TCO)降低至原来的十分之一。

2016年的Google I/O开发者大会上,谷歌首席执行官Sundar Pichai正式向世界展示了TPU这一自研成果,初代TPU 采用了 28 纳米工艺制造,运行频率为 700MHz,运行时功耗为 40W,谷歌将处理器包装成外置加速卡,安装在 SATA 硬盘插槽中,实现即插即用。TPU 通过 PCIe Gen3 x16 总线与主机连接,可提供 12.5GB/s 的有效带宽。

但初代TPU并非谷歌自己独立打造,它的背后,离不开博通的助力。

根据2020年摩根大通分析师Harlan Sur的报告,谷歌TPU v1至v4这几代均是它与博通共同设计的,当时它已经开始生产采用7nm 工艺的TPU v4,并开始与谷歌合作设计采用5nm工艺的TPU v5。

Sur表示,博通的专用集成电路(ASIC)业务2020年全年收入为 7.5 亿美元,高于 2016 年的 5000 万美元,除了芯片设计之外,博通还为谷歌提供了关键的知识产权,并负责了制造、测试和封装新芯片等步骤,以供应谷歌的新数据中心,博通还与其他客户如meta、微软和AT&T等公司合作设计ASIC芯片。

这位分析师还在2022年5月表示,meta正在使用定制芯片来构建其 metaverse 硬件,成为博通下一个价值数十亿美元的 ASIC 客户,“我们相信,这些成果主要集中在 5 纳米和 3 纳米工艺上,并将用于支持 metaverse 硬件架构,该架构将在未来几年内部署,meta 将在未来三到四年内成为博通继谷歌之后下一个年产 10 亿美元的 ASIC 客户。” Sur谈到。

在人工智能元年到来之前,博通就与谷歌meta勾肩搭背,极大拓展了自己在数据中心芯片市场中的份额,而在2023年人工智能爆火后,微软所推出的Maia 100芯片,以及其尚在研发中的网卡,背后可能都有博通的参与,依靠着这几个巨头,博通成为了一人之下万人之上的AI赢家。

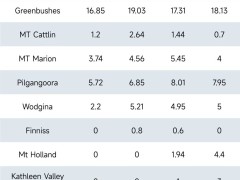

博通的最新财报也体现了这一点,其2024年*季度财报显示,该季度半导体营收73.9亿美元,同比增长4%,营收占比62%,其中网络营收33亿美元,同比增长46%,占半导体营收45%,主要由两大客户定制DPU芯片增长拉动,预计2024年网络营收同比增长35%+。

值得一提的是与AI相关的业务,博通将 AI ASIC 和专注于 AI 的网络解决方案一起归类为 AI 加速器,截至2023年,该业务总销售额合计占全年半导体收入的 15%,即约 42 亿美元,而2024年*季度 AI营收约23亿美元,占半导体营收31%,较前一年同期翻了四倍,预计2024年总占比会在35%以上,意味着2024年AI营收规模超100亿美元(此前预计75亿美元),预计同比增长约133%左右;

而在营收超100亿美元的目标当中,定制DPU芯片约70亿美元,20%是交换机/路由器芯片,10%是光芯片以及互联芯片等,这就意味着,光是为谷歌、meta和微软这样的巨头定制芯片,就能赚得盆满钵满。

博通首席执行官 Hock Tan 丝毫不掩饰自己对AI以及定制芯片的乐观,他在财报电话会议上表示:到 2024 财年,网络收入将同比增长 30%,这主要得益于网络连接部署的加速以及超大规模企业中人工智能加速器的扩展,预计生成式 AI 的收入将占半导体收入的 25% 以上。

与*的博通相比,Marvell在定制芯片上的规模稍小,但同样拥有不容小觑的实力,2023年4月,Marvell发布了基于台积电 3 纳米工艺打造的数据中心芯片,这也是全球*家以芯片设计公司名义发布的3纳米芯片。

2023年6月,台 湾媒体自由时报报道称,Marvell 获得亚马逊 AI 订单。通过此次合作,Marvell 将协助亚马逊第二代 AI 芯片(即Trainium 2)的设计,预计2023年下半年启动委托设计,2024年进入量产。

早在 2020 年12月,亚马逊就推出了一款全新的机器学习定制训练芯片 Trainium,与标准的 AWS GPU 实例相比,AWS 承诺可带来 30% 的吞吐量提升、以及降低 45% 的单次引用成本,随后亚马逊又在2023年11月推出了升级版Trainium 2,这两代芯片推出的背后,也少不了Marvell的影子。

在Marvell官网上,更是直白地提到自己是AWS的战略供应商,提供云优化芯片,帮助满足AWS客户的基础设施需求,包括提供电子光学、网络、安全、存储和定制设计解决方案,考虑到亚马逊目前是全球*的云服务提供商,且谷歌有意于从博通转向Marvell,其在定制芯片上的实力可见一斑。

在Marvell发布的截止至2024年2月3日的第四财季与年度财务报告中,2024财年第四季度营业收入为14.27亿美元,超出中旬时所给出的预期。Marvell的董事长兼首席执行官马特·墨菲先生对此强调:“我们的Marvell 2024财年第四季度营收突破了14.27亿美元,超过了预期。而人工智能带来的收入增长更是惊人,使我们的数据中心终端市场的收入环比增幅达到38%,同比增长则高达54%。”

有意思的是,在此前的2024年第三季度财报中,Marvell就宣布自己通过为云供应商开发定制芯片,在云计算领域也实现了增长。首席执行官墨菲表示:“云计算客户仍然专注于通过构建他们自己的定制计算解决方案来增强他们的人工智能产品,我们已经赢得了许多这样的设计。”

虽然不清楚Marvell与哪些巨头达成了合作,但其中必然有亚马逊的席位。从Marvell 2017年收购Cavium,2019年收购Globalfoundries的ASIC业务部门Aquantia,2020年收购了光芯片厂商Inphi,2022年收购网络交换芯片厂商Innovium这一番布局来看,其图谋所求还是挺大的。

此外,相较于博通依靠巨头的做法,Marvell的押注更加关键,早在2020年9月,Marvell就帮助今年爆火的Groq 设计生产出了Groq Node,其中Marvell 提供了构建 ASIC 及其与外界接口的构建块,而 Groq 自己则专注于人工智能加速。

博通与Marvell,足以称得上是人工智能时代里的定制双雄。

谁是对手

虽然博通和Marvell并未获得英伟达那样的关注度,由于非AI业务的拖累,现在的财报不够好看,股价也难以与英伟达比拟,但它们背后所潜藏的广阔市场足以让英伟达侧目。

“超大规模数据中心企业自己做芯片比向外大量购买还要便宜,并省掉了中间商的成本。”EDA工具与知识产权巨头Cadence数位与签核部门VP Kam Kittrell认为,“这些公司通常是自家云端服务的使用者,并且拥有高价值的专门化软件。他们可以针对这些软件打造能源效率更佳的专属硬件。”

“我们看到*的成长是来自于数据基础架构的领域,包含云端、数据中心、网络、储存设备,以及5G基础架构等应用。”Alphawave Semi行销主管Sudhir Mallya表示:“从今天来看,定制化芯片在数据中心基础架构应用上的成长幅度实在惊人。从几年前Google、微软、AWS、meta等超大规模数据中心企业都纷纷开始设计自家芯片,我们就看到了这个趋势。”

据研究公司 650 Group 的 Alan Weckel 估计,数据中心定制芯片市场今年将增长至 100 亿美元,到 2025 年将翻一番。Needham 分析师 Charles Shi 表示,到 2023 年,更广泛的定制芯片市场价值约为 300 亿美元,约占全球芯片年销售额的 5%。

“博通的定制芯片业务达到 100 亿美元,而 Marvell 的规模约为 20 亿美元,这是一个真正的威胁,”芯片研究集团 SemiAnalysis 的创始人迪伦·帕特尔 (Dylan Patel) 表示。“这是一个真正的大利空——有更多的竞争者加入了战局。”

有意思的是,英伟达CEO黄仁勋最近在斯坦福的演讲里,也提到了这一广阔市场,他表示,英伟达不仅有来自竞争对手的竞争,还有来自客户的竞争(云服务厂商),客户可以为特定的算法构建一款优秀的芯片(ASIC),但计算不仅仅是关于transformer,更何况英伟达正在不断地发明新的transformer变种。

黄仁勋着重提到了成本,他表示,购买和销售芯片的人仅仅考虑的是芯片的价格,而运营数据中心的人考虑的是整个运营成本、部署时间、性能、利用率以及在所有这些不同应用中的灵活性。总的来说,英伟达的总运营成本(TCO)非常好,即使竞争对手的芯片是免费的,最终算下来它也不够便宜,英伟达的目标是增加更多价值,以至于替代品不仅仅是关于成本的问题。

作为英伟达实际掌控人的他,首先对目前的ASIC芯片表达出了不屑,而后他表示,只要有需要,英伟达随时可以利用已有的IP和技术积累,为客户打造出更好的定制芯片,这也与前文中路透社的报道相吻合。

“我们是否愿意定制化?是的,我们愿意。为什么现在的门槛相对较高?因为我们平台的每一代产品首先有GPU,有CPU,有网络处理器,有软件,还有两种类型的交换机。我为一代产品建造了五个芯片,人们以为只有GPU一个芯片,但实际上是五个不同的芯片,每个芯片的研发成本都是数亿美元,仅仅是为了达到我们所说的“发布”标准,然后你必须将它们集成到一个系统中,然后你还需要网络设备、收发送器、光纤设备,以及大量的软件。运行一个像这个房间这么大的计算机,需要大量的软件,所以这一切都很复杂。如果定制化的需求差异太大,那么你必须重复整个研发过程。然而,如果定制化能够利用现有的一切,并在此基础上增加一些东西,那么这就非常有意义了。也许是一个专有的安全系统,也许是一个加密计算系统,也许是一个新的数值处理方式,还有更多,我们对这些非常开放。我们的客户知道我愿意做所有这些事情,并认识到,如果你改变得太多,你基本上就全部重置了,浪费了近千亿美元。所以他们希望在我们的生态系统中尽可能地利用这些(减少重置成本)。”

事实上,隔壁的两家早已在数据中心芯片上不断推陈出新。AMD有Instinct计算GPU,以及EPYC处理器(采用chiplet设计),解决AI和HPC工作负载;Intel则采用多方位策略,运用单体的Habana处理器处理AI应用,多芯片的Data Center GPU Max处理AI及HPC应用,以及多芯片的第四代Xeon可扩充CPU处理其余应用。

还在采用单体设计的英伟达H100,目前在AI上的竞争力依旧强大,但这种优势并非无法消弭,尤其是考虑到它昂贵的价格。像亚马逊、谷歌、meta、微软这样的云服务巨头,他们既有开发定制化数据中心芯片的雄厚财力,也有为之设计一套配套软件的技术能力,为了提升效率和降低成本,本就在往这一方向上发展,AI的到来只是加速了向定制化芯片迁移的过程。

当云服务厂商率先转向定制芯片后,所生产出来的芯片不仅服务自身,还可以开放给其他厂商,长此以往就是定制芯片比例越来越高,英伟达芯片比例就会越来越少,如今它所构筑出的2万亿帝国可能就会在顷刻间崩塌。

黄仁勋的演讲中,一方面强调成本,表达出“定制芯片很不错,但算下来还是我的芯片更划算”的意思,另一方面也对定制芯片持有开放态度,先安抚住自己这群躁动的客户再说,成本高?给你优惠,定制化?先提需求,有什么问题不要急,我们坐下慢慢谈。

这种态度,实际上体现出了英伟达如今的左右为难,还记得文章开始所提到的黄仁勋的感言吗?英伟达把客户需求而不是竞争对手放在*位,这一招让英伟达在GPU市场里横行了二十余年而未尝一败,但当客户变成对手时,多少是有些尴尬的。

从这一角度看,博通和Marvell倒也不用过于担心英伟达横插一脚,一旦英伟达开启定制化芯片的先河,那就会引发一场厚此薄彼的矛盾,英伟达B100和定制化芯片哪个更好,不同的定制芯片又有怎样的性能差异等等,这都是黄仁勋未来所需要考虑的问题。

写在最后

英伟达现在所涉及的领域之广,绝非昔日能比,2008年的英伟达可能只需要盯着AMD和英特尔就行了,但2024年的英伟达,要盯着的厂商数量早已翻了好几倍,且都不是等闲之辈。

而它最近向美国证券交易委员会提交的文件中,也放入了一堆竞争对手,英特尔、AMD、博通、高通、亚马逊和微软都位列其中,面对几个巨头的咄咄逼人,英伟达再淡定,额头多少也沁出了一些汗珠,并非像以往那样风淡云清。

或许英伟达现在真的需要思考下,不把打败对手当成目标了。

85603/18

85603/18